EL ALGORITMO DE LA RAZA. NOTAS SOBRE ANTIRRACISMO Y BIG DATA

EL ALGORITMO DE LA RAZA. NOTAS SOBRE ANTIRRACISMO Y BIG DATA

Por Anyeli Marin Cisneros

La dictadura de las imágenes está ligada a la ficción de la raza. Aquí nace el principio de la dominación del ojo. Este texto propone una serie de comentarios acerca del racismo en el neoliberalismo y la era del big data. Formula algunas preguntas acerca del estatuto del cuerpo en relación con la biometría y la vigilancia digital. Se pregunta por un posible antirracismo tecnocientífico, como una tentativa ante la cuestión por el futuro de la raza.

Todo relato sobre la tecnología digital ha sido incesantemente planteado como una promesa del futuro. Por oposición, toda referencia a la colonialidad y al racismo, la esclavitud y la acumulación originaria, es imaginada en un tiempo pasado y se le atribuye a un ciclo cerrado y acabado. El espeso velo del tiempo lineal nos somete a la imposibilidad de comprender la hibridez de los ciclos y de las formas de poder superpuestas. ¿Cómo escribir sobre tecnología sin evocar sus promesas? ¿Qué relación hay entre racismo y digitalización? ¿Cuál es el tiempo de la raza?

EL TIEMPO DE LA RAZA

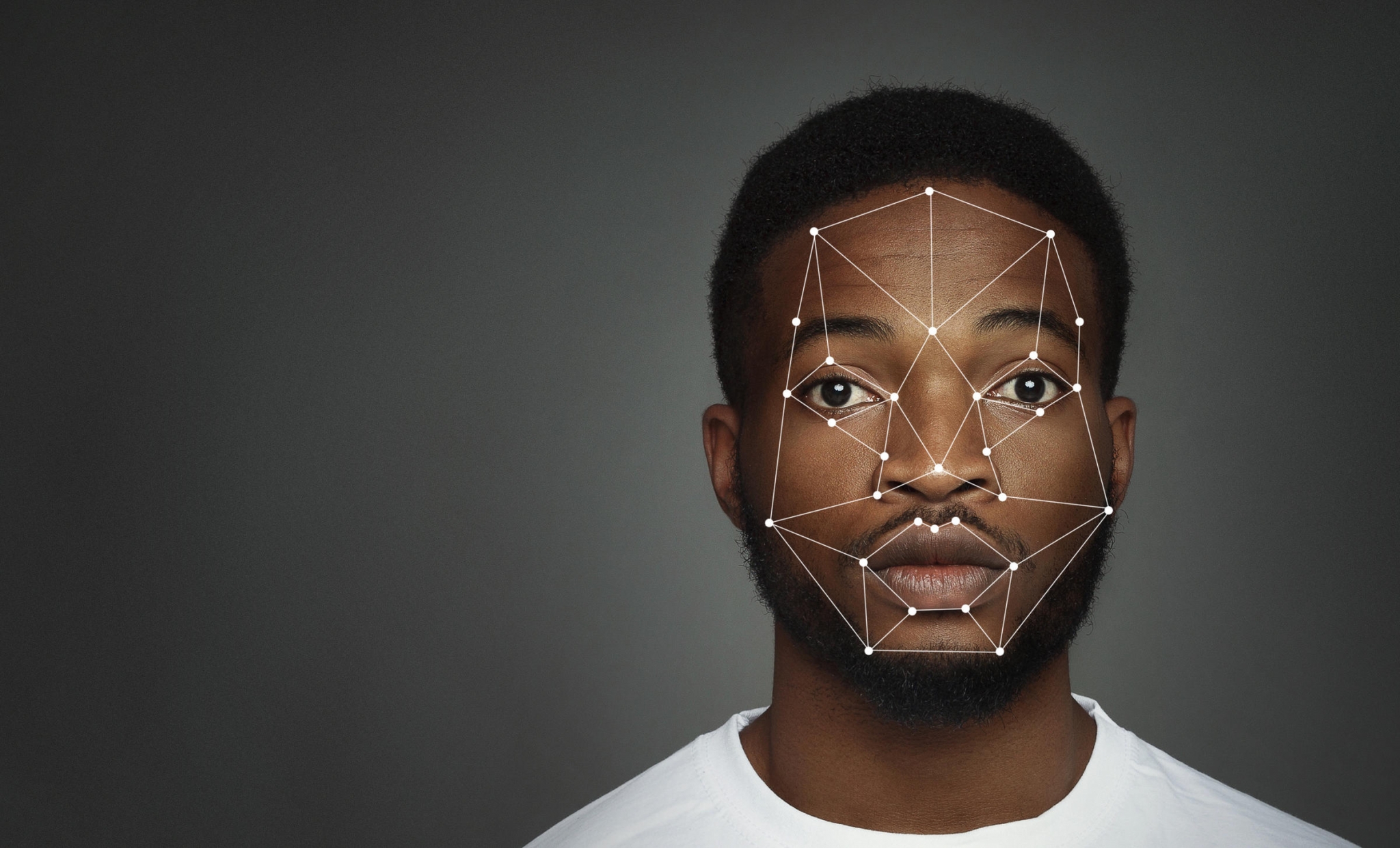

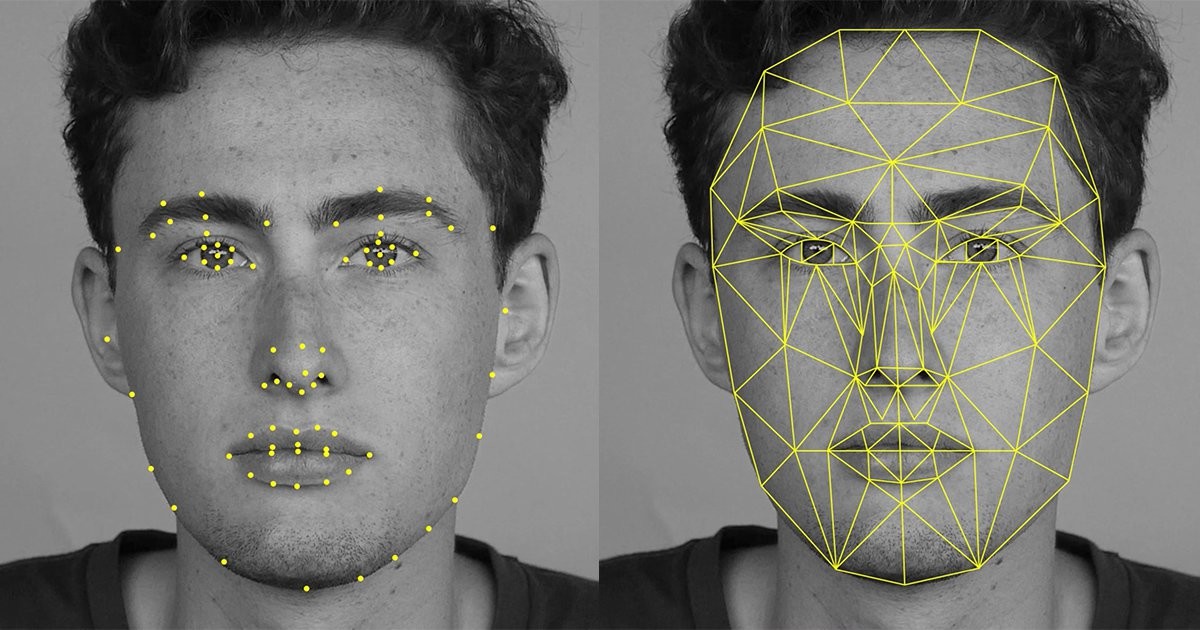

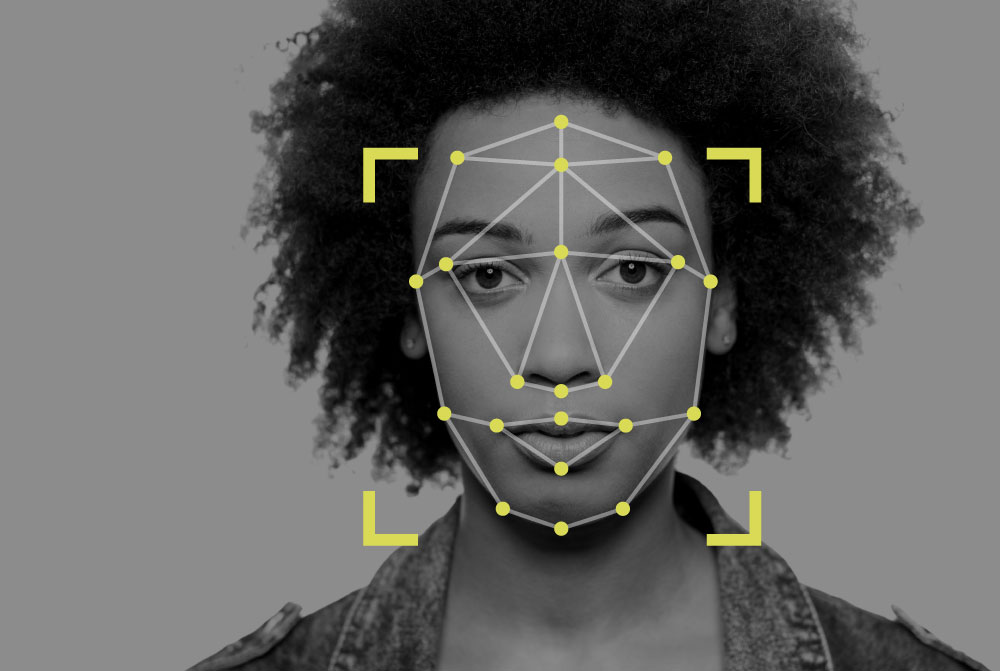

El gobierno chino acaba de incorporar gafas de reconocimiento facial al equipamiento básico del cuerpo policial de esa nación. Así, en 2018, Asia se pone a la vanguardia de la frenología tecnotrónica bajo nombres como “inferencia automatizada de la criminalidad con imágenes faciales”. La detección facial supone que además de determinar plenamente la identidad de las personas, también se puede tener información sobre la predisposición moral. Activistas de diversas partes del mundo comparten estrategias para burlar esta nueva avanzada de la hipervigilancia. Se proponen diseños analógicos y digitales para hackear y confundir el implacable panóptico. A su vez, grupos de activistas negrxs de los EEUU, denuncian la emergencia del racismo digital palpable en la programación de softwares para el reconocimiento de personas. Reclaman por tanto “justicia algorítmica” en el diseño de programas fiables en la lectura de la tez y los rasgos afros. Exigen ser ampliamente reconocibles por la visión artificial. Prevén que la inminente aplicación de estos softwares imperfectos en el sistema judicial perpetúe las injusticias raciales del sistema.

Contravigilancia o inclusión; anonimato o fiebre de archivo identitario; deserción de las categorías de raza o sobreidentificación minoritaria. La ambivalencia del racismo en la tecnología nos abre a un campo de problemas que comienzan por comprender las implicaciones del proceso actual de la digitalización del mundo.

Achille Mbembe plantea que la ficción de la raza y el racismo no solo comparten el pasado sino que proyectan un porvenir cifrado en la digitalización del presente. Por ello, queremos hablar de tecnología sin fijarla en el tiempo futuro. Hablar de exclusión, empobrecimiento, expoliación y tecnocolonialidad desmontando el aparataje que encubre este acelerado reordenamiento político y material, fundamentado en la fragilización de los cuerpos a través del orden digital. Es imprescindible entonces suspender momentáneamente la discusión en torno al “racismo” y poner en el centro del examen la noción de “raza”. Plegar el tiempo para interrogar las inscripciones de la supuesta diferencia abismal que fue tomando forma en los siglos coloniales y luego siguió codificando todos los aspectos de la realidad, desde el sexo hasta la macroeconomía. Es urgente interrogar la génesis de esa forma de poder y sus consecuencias en el presente, habitado por lógicas vertiginosas de segmentación étnica y fragmentaciones identitarias.

“Grupos de activistas negrxs de los EEUU, denuncian la emergencia del racismo digital palpable en la programación de softwares para el reconocimiento de personas. Reclaman por tanto “justicia algorítmica” en el diseño de programas fiables en la lectura de la tez y los rasgos afros. Exigen ser ampliamente reconocibles por la visión artificial. Prevén que la inminente aplicación de estos softwares imperfectos en el sistema judicial perpetúe las injusticias raciales del sistema.”

LA MIRADA CODIFICADA

“Raza” es un invento moderno introducido como vector de división y estratificación de la fuerza de trabajo, tanto en la producción como en la reproducción sexual, en la Colonia. Tuvo un primer intento de legitimación en el siglo XVI, en un uso inédito hasta entonces de esa palabra, para referirse a los supuestos indios. Como se sabe, el delirio original es ibérico, un intento fallido, un primer atisbo, que aun así trajo gravísimas consecuencias. En ese entonces “raza” no estaba fijado al color de la piel ni a ninguna otra característica sensible (Quijano, 2017), pero sí a una duda sobre la existencia del alma. El alma era el índice de pertenencia a la raza humana. En el principio raza nos significaba a todos. Para que la noción de “raza” llegara a expresar lo que expresa hoy, debió ser cargada, modificada y transferida a una materialidad palpable.

En el siglo XVII “raza” se asienta con la fuerza de la legitimación que se otorga a sí mismo el sistema de creencias de la razón moderna. El significado de raza se transforma atravesando un vaivén sangriento, de dominación y resistencias, a lo largo del siglo. Las resonancias de la Arqueología del saber de Foucault son reveladoras. Efectivamente, la emergencia de la “raza” nos sitúa en un circuito de instituciones, vocabularios específicos y conceptos asociados al cuerpo humano subdividido en especies. Un proceso lento, en cámara de eco, entre la práctica colonial y la ciencia, entre las convenciones sociales y las leyes, que le van dando forma a la encarnación del delirio racial. Raza queda fijado al cuerpo negro como único “sujeto de raza” por mucho tiempo. He aquí el origen de una economía que se levantó a costa de subsidios raciales gracias a la transferencia de un vector de división a una corporalidad específica.

Desde entonces, la verificación de esa diferencia ha sido el motor del saber. Subdividiendo lo humano en partes, se ha buscado y rebuscado en la forma del cráneo o los rasgos de la cara, en la musculatura, en los dientes o en el tamaño de los genitales, en la psique o en la lubricidad del carácter. Hasta bien entrado los 2000 diversos laboratorios de punta concentraron tiempo y recursos a la caza de la diferencia racial en la secuencia genética. La gran noticia de la era del genoma es que no existen razas humanas. Pero acá está nuevo el eco del racismo, en la acusación o en la defensa, en el error o en la aclaratoria. Es el eco de la rabia y la vergüenza que supone para nosotros los “sujetos de raza” la obsesión blanca por la supuesta diferencia. La aplicación de leyes esclavistas marcó el paso de una economía de cultivo artesanal a una economía industrial de gran escala que desató una competencia feroz entre los imperios coloniales concentrando fuerzas en el Caribe, empujando desde allí la transformación de los modos de producción en el resto del continente hacia formatos de mayor y mejor extracción, perpetrando genocidios y secuestros masivos de personas para su explotación con un impacto incalculable.

Al ritmo de la intensificación industrial, “negro” va a pasar a significar “esclavo” y viceversa a partir de la rígida prohibición de emplear serviles blancos en el sistema de plantación, alrededor de 1660. Para no dejar lugar a dudas, las leyes para gestionar a la población esclavizada se denominaron Códigos negros. Estos atestiguan la imposición y documentan la puesta en práctica de una lógica de jerarquías y estratos humanos: la “raza”, esa obra fundamental de la racionalidad europea, que le dio forma a la economía libidinal, psíquica y estética que llamamos racismo.

Los Códigos negros o las leyes esclavistas fueron el conjunto de normas jurídicas coloniales, diseñadas en las metrópolis europeas, testadas en los laboratorios tropicales del sistema de plantación y corregidas violentamente en la marcha para administrar el tiempo de trabajo, la sexualidad, la reproducción, la penalidad y la movilidad de los esclavizados, naturalizando las jerarquías.

Los Códigos negros, también conocidos en el arcaico vocabulario del imperio español vigente hasta finales del siglo XIX como “reglamentos para la educación, trato y ocupación de los esclavos”, hoy pueden entenderse como el lenguaje originario del racismo contemporáneo. Estos códigos cumplieron la función de identificar, diferenciar y segregar ámbitos de la vida cotidiana, fijando determinados cuerpos a espacios y tiempos diferenciados. Para sustituir el hecho de que la población negra no tenía permitido recurrir a los tribunales, los códigos establecieron penas tarifadas, una determinada cantidad de latigazos según las faltas cometidas, de modo que el castigo no pasaba por la voluntad del amo, sino por la instrucción del sistema legal de las metrópolis. Las raciones de alimentos, la discreción por sexo y edad de los dormitorios, los horarios de trabajo y descanso, y en general el biorritmo calculado para someter, explotar y embrutecer el cuerpo sin destruirlo eran instruidos desde París o Madrid, como consta en los sellos y firmas de los legajos.

La sexualidad de los cuerpos esclavizados merecería una revisión aparte, centrada en la obsesiva instrucción sobre la gestión de la vida sexual, el maridaje y la reproducción, la lactancia y la menstruación. Desde 1660 el poder colonial vigiló con celo el estatuto de los nacimientos (se nacía libre o esclavo según el estatuto de la madre) como elemento importante de la nomenclatura del poder. Mientras “el amo entiende que el esclavo le pertenece hasta en la función de reproducción (…) Su margen de maniobra sexual estaba sujeto al margen de beneficio del amo. El goce no era una conquista, no era un proyecto, era un hurto. No era una prolongación en sí mismo, era lo que se deduce del Otro, el Otro siempre presente, mirón, invisible y represor” (Glissant, p. 281). Por un lado se estimulaba la reproducción de la clase esclava, pero por otro lado se temía a la resistencia desbordante, a través de lazos libidinales y sanguíneos que representaban una amenaza latente para el funcionamiento de los engranajes de la industria azucarera: las “herramientas vivas” deseantes y fértiles profundamente aliadas.

“Raza” en tanto escritura algorítmica, con su inherente función de manual de entrenamiento básico para el ojo racista, describió y estandarizó patrones para la dominación por efecto de la segregación. Lo primero fue romper alianzas entre grupos subalternos. Crear una división entre esclavos y serviles (1660-1663). Fijar la esclavitud al cuerpo negro y prohibir la esclavitud de los blancos (1670-1685). Impedir los matrimonios interraciales (1711-1724). Castigar con la servidumbre a las mujeres blancas que manifestaran su deseo por hombres negros (1691). Declarar la esclavitud desde el nacimiento para los hijos de las esclavas (1690-1700). Imputar duros códigos sociales de apartheid para debilitar a la comunidad negra libre (1730).

Los códigos franceses o los reglamentos españoles fueron modelos repetibles que consistían en anular el Común entre los subalternos, creando una enrevesada taxonomía de lo humano. Reescribieron normas para inventar diferencias en aspectos vitales y convertir ese índice diferenciador en una frontera constitutiva. Nos asomamos al vértigo del tiempo superpuesto de la raza: estos códigos legales y sociales del siglo XVII le dan forma a la gramática racista que seguimos discutiendo en el siglo XXI . Son la base del sistema de control migratorio contemporáneo y representan el punto de vista del que parte la vigilancia digital, la creación de algoritmos selectivos y las bases de datos biométricos en auge.

La identificación (del negro), la diferenciación (del negro como esclavo, del blanco como patrón), la segregación (de la vida civil) y la cualificación afectiva y sexual (del negro como peligro) dan cuenta de queel índice de “raza” funcionó como una partitura de la realidad. Como una coreografía para el afecto a partir del cercamiento y la exclusión para unos y el reparto de privilegios de nacimiento para otros. Desde mediados del siglo XVII, entre 1663 y 1680, las leyes de raza establecieron que “cualquier blanco” estaba autorizado —más tarde obligado— a matar a cualquier persona negra que hallase en su camino, fuera de la plantación. No se trataba solo de delatar, era su deber aniquilar a los fugitivos. Esta ley en particular da cuenta de la racialización del espacio público a partir del empoderamiento soberano de los blancos.

Se registra así el delineamiento progresivo de una subjetividad vigilante entrenada en ansiedades raciales: la población blanca se va convirtiendo en policía de la raza, una sensibilidad racista que es palpable hasta el día de hoy. Un sujeto vigilante que aún se siente autorizado a preguntar, consciente o inconscientemente, ¿qué hace este negro aquí?, ¿por qué se atreve a pensar?, ¿por qué estas personas están ocupando este lugar?

BIO- BIG DATA

De modo que la emergencia de un racismo diagramático del orden social y estético no fue un accidente. Las definiciones de raza han sido inestables y cambiantes, transformándose al ritmo de las mutaciones de la biociencia a la genómica (Haraway, 266) y de todos modos, sus mutaciones han estado atravesadas insistentemente por la racialización del trabajo, la sexualidad, el espacio público y la relación jerarquizada con la técnica y la tecnología (sujetos de ciencia / objetos de estudio).

“Raza” y sus variaciones tecnodigitales son categorías que están en el centro de la industria de los sistemas sofisticados abocados a escrutar el cuerpo para extraer datos en sus mínimas divisiones genéticas y en sus máximas expresiones emotivas. Si la biotecnología está tamizada por lógicas de diferencia racial en lo pertinente a selección de embriones, de tejidos y de células y la gramática racial atraviesa el gran proyecto securitario y de vigilancia global, es porque “raza” fue y sigue siendo una tecnología de poder para extraer beneficios.

En adelante, estaremos inmersas en la fabricación de la memoria artificial a escala global, en el tiempo en que “la potenciación del Estado securitario trae aparejada una remodelación tecnológica del mundo y una exacerbación de los modos de asignación racial” (Mbembe, 2013, p. 59). En la obsesión de fronteras y vigilancia del capitalismo financiero, el cuerpo humano, sus rasgos y huellas, halos y temperaturas, rastros digitales y físicos están siendo tasados como datos biométricos que producen ganancias. Esta obsesión del capitalismo de datos enfatiza la falsa “necesidad de Estado” en el relevo de la información analógica a datos digitales. La digitalización de datos para la gestión del Estado, no es otra cosa que la exacerbación de los rasgos físicos y los orígenes de los ciudadanos, poniendo de relieve constantemente las procedencias étnicas y/o nacionales de los depositarios. A pesar de no interrogar directamente sobre “raza”, el escrutinio ronda permanentemente alrededor de esta noción, pasando y repasando por los múltiples sustitutos de la asignación racial.

Como puede suponerse a partir de las inversiones millonarias en tecnologías de reconocimiento facial, se pretende extraer una verdad interior, predictiva y calculable a partir de rasgos, desde la gestualidad hasta el timbre de la voz. La digitalización supone que el entrenamiento analógico del ojo racista está siendo perfeccionado gracias a la obtención de información invisible e inaudible para la percepción humana. La digitalización releva entonces el lugar que había adquirido la raza como mito y como prejuicio y la reviste de una nueva legitimidad, como un concepto duro, veraz y verificable. ¿Es posible seguir hablando de prejuicios raciales en este escenario? ¿No es suficiente la promesa del futuro racializado en todos los ámbitos que la tecnología le está ofreciendo al cuerpo en la era del big data? ¿No es evidente que entre el resurgimiento de nuevas formas de esclavitud en el Sur global y las tecnologías mortíferas en las fronteras de Europa existe un campo de relaciones e interdependencias que atraviesan el cuerpo? ¿Cuáles son los nuevos sujetos de raza del big data?

Hasta ahora, al menos dos categorías de sujetos se han revelado en este escenario y entre ellos existe una frontera racial: “la humanidad superflua, totalmente prescindible para el funcionamiento del capital” (Mbembe, 2016, p. 29) y los “sujetos de deuda” (Lazzarato, 2013) o vidas atadas al vínculo como deudor.

Las redes de dominación de raza interceptan nudos de poder entre la alta tecnología de guerra, el ojo digital de las fronteras o el flujo de datos. Tejen puntos de subjetivación entre pequeñas máquinas culturales como los emojis de color para la confesión de raza en las redes, con el diagrama de múltiples racismos que van de la pobre tropicalización de los gustos musicales a escala global, al flujo de capital sin necesidad de trabajadores; del jugoso negocio de la migración prohibida a la proliferación de divas, marcas y productos de belleza bajo subsidios publicitarios raciales.

“Esta obsesión del capitalismo de datos enfatiza la falsa “necesidad de Estado” en el relevo de la información analógica a datos digitales. La digitalización de datos para la gestión del Estado, no es otra cosa que la exacerbación de los rasgos físicos y los orígenes de los ciudadanos, poniendo de relieve constantemente las procedencias étnicas y/o nacionales de los depositarios. A pesar

de no interrogar directamente sobre “raza”, el escrutinio ronda permanentemente alrededor de esta noción, pasando y repasando por los múltiples sustitutos de la asignación racial.”

El cuerpo es la palanca que mueve distintos niveles de la compleja cadena de estas redes de dominación. Por esta razón, el cuerpo es invitado a indicar detalladamente cada diferencia, sometido a un cuestionario digital en progreso. El cuerpo sexuado, afectado, frágil alimentando un archivo infinito, alejado de su “derecho de opacidad”, obligado a decirlo todo. El cuerpo hurgado en sus capas más profundas, exiliado de su intimidad, pasando el túnel del delirio de raza. El cuerpo en el tiempo sin refugio.

EL ALGORITMO DE LA RAZA

Los tecnólogos críticos, preocupados por la multiplicación de injusticias y el reparto masivo de pobreza que se avizora como legado del gobierno big data, nos explican que los nuevos algoritmos son secuencias de códigos diseñados para leer, organizar, filtrar y analizar la gran cantidad de datos que fluyen entre descomunales archivos informáticos del mundo. Lo que diferencia a estos algoritmos de otro tipo de secuencias de bits, es que estos son perversos y polimorfos, tal como Freud describía a los niños, entes juguetones y al mismo tiempo monstruosos cuya naturaleza radica en desbordar rápidamente su escritura original. Tienen la capacidad de ‘aprender’ de los humanos porque en cada interacción (en el uso de apps, búsquedas, descargas de archivos, patrones de navegación y preferencias), nutrimos con datos y entrenamos unos modelos matemáticos que expanden y fortalecen sus habilidades incorporando el conocimiento que acabamos de compartirles.

La preocupación surgida alrededor de estos está relacionada con su condición de fantasmas autónomos, que toman decisiones más allá de la voluntad de los usuarios. Una de las voces más importantes de este debate, la matemática Cathy O’Neil (2018), explica que la legitimación de la gobernanza propia del big data, ejecutada por algoritmos aprendices, pone en peligro la democracia como un pacto entre personas y aumenta la exclusión social, en buena medida, debido a la acumulación de información, inabarcable a escala humana.

En la segunda parte del siglo, sin embargo, es el signo monetario el que reclama su autonomía, y desde la decisión de Nixon, tras un proceso de desregulación monetaria, quedó firmemente establecido que la dinámica monetaria se autodefine de manera arbitraria: el dinero pasó de tener una significación referencial a tener otra autorreferencial. Esto era necesario para la automatización de la esfera monetaria, y para la sumisión de la vida social a esta esfera de abstracción.

Ese es el paisaje tecnoafectivo en el que el dato “raza” se desliza de una manera ambigua y resbaladiza. La misma Cathy O’Neil, aun cuando el enfoque de su investigación es la vocación especulativa de los usos hegemónicos del big data, pone en el centro de su argumentación una metáfora racial para llevarnos a entender las lógicas algorítmicas a las que estamos expuestas. Ella compara el funcionamiento del racismo y el de las “armas de destrucción matemáticas” indicando que tanto el racismo cotidiano como los algoritmos son modelos predictivos que se nutren de datos recogidos al azar, no verificados y alimentados por otros datos imperfectos, cuya procedencia se desconoce. Ambos modelos operan como bucles que se retroalimentan a sí mismos (p. 33). Investigadoras como Timnit Gebru, directora del departamento de Ética de Microsoft, y organizadora de la conferencia Black in AI, llama la atención sobre lo que ella llama “crisis de diversidad en de visión artificial”, diversidad de datos y de cabezas pensantes. Cuando se hace referencia a los peligros algorítmicos, el racismo es el ejemplo por excelencia. Tomemos esta reiteración como punto de partida para revisar por qué y cómo “raza” aparece en el discurso actual de la tecnología.

Un lunes cualquiera de enero de 2018, como para agitar las redes aún dormidas al inicio del año, los portales de noticias más leídos en las principales ciudades —al menos de España y América Latina—, reprodujeron casi textualmente una “gran” noticia tecnológica de los Estados Unidos: “Google ha eliminado su algoritmo racista”. ¿Sabíamos que Google tenía un algoritmo de imágenes humillantes para personas negras? ¿Era importante que ese titular le diera la vuelta al mundo? ¿Contribuía a alguna causa o respondía a demandas de activistas antirracistas tecnofílicos? Habían transcurrido dos años desde que no se hablaba de ese algoritmo en particular y ya era un tema olvidado. El titular tuvo el único efecto que podía tener: el motor de búsqueda de nuestra preferencia se saturó ese día y toda la semana siguiente, llenando los depósitos algorítmicos con el favor de los usuarios, quienes enseguida quisieron confirmar la voluntad descolonizadora de Google. Las navegaciones y búsquedas “aleatorias” se combinaron con incursiones y comentarios en las redes, likes, RT, descargas, a la caza de la injusticia o la justicia del algoritmo en cuestión. Así se puso en marcha lo que Benjamin Cadon describe como el riesgo de un “bestiario algorítmico” que se multiplica y retroalimenta entre la inteligencia humana y la artificial, entre los datos estimulados y la mente. En este caso, entre las pesquisas inducidas y los hallazgos preestablecidos (2018, p. 35).

Todas las grandes firmas tecnológicas cuentan con un kit de algoritmos que dejan ver las “ansiedades raciales” (Haraway) que hoy corre por la tecnología de datos. Como era de esperarse, todas tienen una serie de bits que parecen escritos por el Ku Klux Klan, como pequeñas máquinas taxonómicas, listas para segregar.

El debate alrededor del riesgo de los algoritmos es también flujo de “habladurías” por parte de los falsos amigos del antirracismo.

Esta habladuría de los “sesgos” racistas, apenas rasca la superficie del problema. La línea argumentativa dominante circunscribe el fenómeno de los algoritmos racistas a un deslizamiento involuntario de los prejuicios sociales hacia la esfera digital. La injusticia humana filtrada hacia el lenguaje neutral de las matemáticas por la acción de una hueste de programadores ciegos ante sus propias tendencias excluyentes. Esto, que de hecho es así, representa apenas un comentario más sobre la ya socavada objetividad de la ciencia, pero ni explica ni cuestiona la reiteración del racismo en el mundo digital, ni señala la masividad, la insistencia del mismo y mucho menos visibiliza la fuerza con las que las lógicas de “raza” y racismo han reaparecido en la escena del capitalismo de datos y en la biotecnología. La preocupación por las matemáticas contaminadas por los prejuicios del hombre blanco expande y ramifica la invención de “raza” en nuevos racismos. Esconde y relativiza la normalización racial debajo de un suerte de mirada oblicua contingente, porque al fin y al cabo, los sesgos son solo sesgos y siempre podrán ser corregidos. Obtura el hecho de que el retorno del racismo face to face y la segregación en el espacio público, está siendo derivado también hacia los algoritmos (des)obedientes que excluyen, invisibilizan o humillan en un proceso en el que la responsabilidad y la voluntad humanas quedan eximidas.

Una excusa apaciguadora para criaturas cortazareanas del tipo tecno-esperanzas: conectadas al anhelo de que la injusticia sea corregida por programadores políticamente correctos; y en el mejor de los casos, a la espera de la irrupción de activistas por la probidad del código. El discurso del sesgo algorítmico nos conduce mansamente a la aceptación de tales “prejuicios” como un estado de cosas insalvables y posterga un debate sobre el hecho de que aún estemos hablando de “raza”. Como si fuera posible una tecnología imparcial pese a la historia moderna.

“Todas las grandes firmas tecnológicas cuentan con un kit de algoritmos que dejan ver las “ansiedades raciales” (Haraway) que hoy corre por la tecnología de datos. Como era de esperarse, todas tienen una serie de bits que parecen escritos por el Ku Klux Klan, como pequeñas máquinas taxonómicas, listas para segregar.”

DESCODIFICACIÓN, DESCOLONIZACIÓN Y RUPTURAS DEL ORDEN DE RAZA

Lejos de colaborar con el rumor sobre los sesgos, el resurgimiento de raza nos abre a un campo de lucha que requiere de nuestra parte un ejercicio de descolonización radical de la mirada codificada. El antirracismo de la era del big data debe desmontar la permanencia de “raza” codificando la tecnología, como ha codificado la realidad en la Modernidad.

El capitalismo de datos discrimina para optimizar sus ganancias y lo hace siguiendo patrones de segregación probados por los Códigos negros: racializa el espacio público, el trabajo, el ocio, la sexualidad y la reproducción. Mueve y promueve las afinidades raciales con ayuda de la socialización virtual y la consignación de geolocalizaciones. De modo que el racismo, la islamofobia, los nacionalismos, el sexismo o la xenofobia no son fenómenos aislados del nuevo comportamiento del capitalismo, por el contrario, son piedras angulares en la economía de especulación, que necesita imágenes, rostros, hábitos y distinciones más o menos fijas.

La emergencia de las segmentaciones raciales en el mundo virtual es notoria por su ambigüedad (son especialmente interesantes las opciones de avatares identitarios en los videojuegos y el menú étnico de los portales de pornografía). Incluso pretendiendo combatir el racismo, denunciar su funcionamiento, visibilizar sus sutilezas, nos vemos obligadas a transitar por la mirada codificada de las descripciones rutinarias del racismo. Nos vemos obligadas a escuchar salir de nuestras bocas el relato racista aún cuando intentamos denunciarlo. Nos escuchamos hablar en el lenguaje de la raza, aún cuando sabemos que es una detestable ficción inventada por otros.

Sin desmantelar la embestida de “raza” como una noción que reorganiza relaciones a escala global y en sus correlatos locales, donde se recrean y contrarrestan las xenofobias territoriales, (piénsese en cualquier barrio pobre de España, Italia o Francia) pierde sentido hablar de racismo o pretender combatir el prejuicio.

Algunos activismos antirracistas apelan a la sobre-identificación racial, como elemento común para crear comunidad y como una fórmula colectiva de restitución de la pérdida y cura de las heridas coloniales. Algunos refutan el racismo, pero se refugian en la idea reconfortante de la raza como una fórmula de contradelirio que roza el sueño de la pureza y el lugar original. Aquí también “raza” adquiere un carácter de verdad donde la cosificación y el estigma se tuercen momentáneamente y se convierten en un llamamiento alegre que evoca linajes rotos o tierras anheladas.

Pero el capitalismo líquido estimula los posicionamientos identitarios a conciencia. El antirracismo, por tanto, está obligado a jugar en el terreno ambiguo de la identidad, pero sin dejar de producir subjetividad fuera de las redes de dominación de raza. Frente al racismo tecnodigital, el antirracismo debe enfrentarse a las promesas monstruosas de la tecnología genómica (las predicciones basadas en evidencia genética o la “puntuación de riesgo poligénico”, por ejemplo) y de la inteligencia artificial empática. El antirracismo debe aprender también a ser ambivalente y desembarazarse de la gramática de raza para reescribir otras nomenclaturas. En el horizonte de las resistencias posibles está el derecho de opacidad, único refugio para el desmontaje de “raza”, gesto absoluto frente a una exigencia, cada vez más asfixiante, de identificarnos exhaustivamente.

En la opacidad es posible la recodificación de la mirada, el entrelazamiento de nuevas alianzas y el éxodo hacia categorías inéditas que nos permita cabalgar lejos de las dolorosas encarnaciones raciales del siglo xvii y lejos de las promesas del futuro.

** Este texto forma parte del catálogo de la exposición The futch, comisariada por Neme Arranz y Marta Echaves, en la Sala de ARte Joven de Madrid en 2018. Resume una investigación en curso junto con Rebecca Close, acerca de flujos de imágenes, contagio y excesos virales.

Anyeli Marin Cisneros forma parte de la plataforma de investigación y acción artística Diásporas Críticas, que desarrolla proyectos, acciones poéticas y talleres de lectura bajo metodologías decoloniales y pedagogías críticas. En sus últimos proyectos exploran y responden a la manera en la que los nacionalismos intervienen el cuerpo y los sentidos, siguiendo nociones como “contagio” y “transmisión” en relación a los medios de comunicación y a los discursos médicos. Han organizado intervenciones, lecturas y programas públicos con museos, centros de arte, universidades y espacios autónomos.